Как вывести сайт в топ 10

Содержание:

- Собираем семантическое ядро

- Подробнее про наиболее интересные из них.

- Google или Яндекс?

- Какие сайты любят поисковики – 4 признака хорошего ресурса

- Анализируем текущее положение с помощью SEO-инструментов

- Определяем целевые страницы для продвижения в Google

- Как поднять сайт в Гугл: алгоритмы ранжирования

- Наличие мобильной версии

- С чего следует начинать любой анализ

- Про поведенческие факторы

- Как поднять сайт в поиске: особенности продвижения в Google в 2021

- Значение всех функциональных элементов

- Особенности продвижения новостных сайтов

Собираем семантическое ядро

Собрать ключевые фразы можно разными способами, я расскажу об одном из них — которым пользуюсь сам.

Чтобы найти конкурентов своего сайта, я использовал функцию «Поиск конкурентов» на MegaIndex. Таким образом можно найти сайты, с которыми у вашего ресурса наибольшее пересечение показов в поисковиках. Я отобрал пару-тройку конкурентов и перешел на Букварикс. Здесь даже в бесплатной версии можно вытащить 1000 запросов у каждого конкурента, что я и сделал.

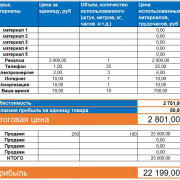

Затем загрузил все запросы в программу Key Collector и выделил самые популярные. По основным запросам спарсил поисковые подсказки. Парсинг можно сравнить с пылесосом, который собирает полезные для нас данные. Также с помощью Key Collector я снял у запросов частоты и почистил дубли. Далее было нужно сгруппировать все запросы, и я перешел в программу KeyAssort. Собрал данные и экспортировал. На выходе получил таблицу со сгруппированными запросами:

Возможно, звучит сложно, но если проделать это один раз, все будет довольно просто.

Возможно, звучит сложно, но если проделать это один раз, все будет довольно просто.

С помощью манипуляций, описанных выше, я собрал полное ядро. Но, чтобы сформировать запросы для одной статьи, можно поступить проще — воспользоваться Яндекс.Вордстат.

Выбираем запрос, по которому будем продвигаться. Я выбрал «природа в индии».

Вводим запрос в Вордстате:Обращаем внимание на запросы и думаем, кого они могут интересовать, чтобы понять, о чем им рассказать в своей новой статье. Например, по запросу «контрасты индии» мой сайт также находится в топе

В Яндекс.Метрике я заметил, что этот запрос часто используют со словом «доклад». Скорее всего, информация на моем сайте будет интересна студентам или школьникам. Я поставил себя на их место и решил, что, если бы я был студентом, мне нужно было бы быстро прочитать интересную информацию и рассказать о ней. Старайтесь думать о тех, для кого вы пишите, и ваш труд окупится.

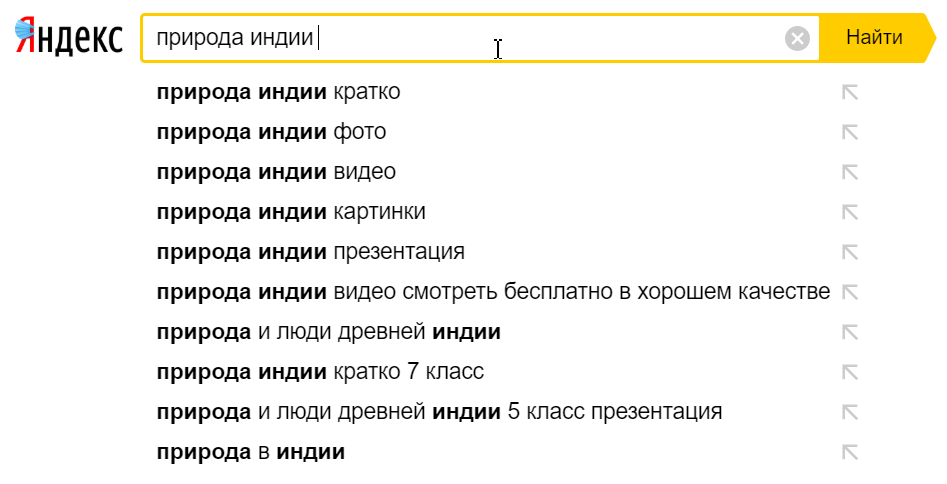

При написании текста нужно выбирать слова, которые часто вводят пользователи. Вы можете найти популярные выражения с помощью подсказок — их можно получить и без Key Collector. Для этого просто вводим в поисковой строке интересующий запрос и смотрим, что предлагается:

Если после ввода запроса прокрутить страницу вниз, увидим следующую картину:

Если после ввода запроса прокрутить страницу вниз, увидим следующую картину:

Это так называемые LSI-фразы, которые необходимо употребить в статье.

Это так называемые LSI-фразы, которые необходимо употребить в статье.

После сбора семантики переходим к написанию текста.

Подробнее про наиболее интересные из них.

Подсветка результатов

Одной из важных особенностей инструмента является возможность подсветки результатов (сайтов), т.е. выделение каждого домена или документа определенным цветом. Благодаря этому можно наглядно представить совпадение результатов выдачи по каждому запросу.

Выделить результаты можно как из левой рабочей зоны со списком всех документов/хостов, просто нажав на интересующий.

Либо это можно сделать из правой рабочей зоны со списком документов в выдаче по каждому запросу.

Для этого рядом с каждым результатом есть две цветных точки , нажав на верхнюю, вы подсветите данный домен в каждом из запросов, в которых он встречается. Нажав на нижнюю, вы подсветите именно этот документ в каждом из запросов, в которых он встречается.

Расчёт видимости и сортировка по ней

Вторая важная особенность инструмента – расчёт видимости и сортировка доменов и документов по ней.

Видимость – показатель, того насколько сайт высоко ранжируется по указанным запросам. Выражаясь проще, это условный показатель вероятность, как часто пользователю будет виден ваш сайт.

Такой подход позволяет выявить сайты с наиболее хорошими результатами по вашему списку запросов, понять, стоит ли на них ориентироваться при анализе.

В инструменте используется простая формула без учёта частоты:

(Σ(k) / N ) * 100

N — число запросов;

k — зависит от позиции, которую занимает документ/домен в выдаче:

1 позиция — 1

2 позиция — 0.95

3 позиция — 0.90

4 позиция — 0.85

5 позиция — 0.7

6 позиция — 0.6

7 позиция — 0.5

8 позиция — 0.4

9 позиция — 0.3

10 позиция — 0.2

11-15 позиции — 0.1

16-20 позиции — 0.05

Отображение подсветок Яндекса

Также по каждому результату можно получить заголовок и описание его сниппета в выдаче с отображением подсветок поисковых систем.

Для удобства работы с результатами, вы можете перемещать их схватив за иконку. Также можно скрыть ненужные результаты, нажав на иконку вверху списка результатов.

Google или Яндекс?

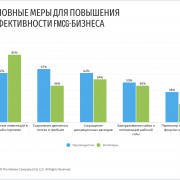

Вплоть до 2017 г. Яндекс был очень популярен среди пользователей. В 2017 поисковая система Google сравнялась с ним по количеству трафика. Все потому, что именно Google заметил, что мобильный трафик стал сильно расти, и сразу использовал эту возможность. Большая часть планшетов, смартфонов, умных устройств выходила с предустановленным поиском Google. Яндекс предпринял удачную попытку переломить тенденцию: подал на Google жалобу в ФАС и выиграл дело. В этом же году гиганты-поисковики на какое-то время сравнялись и поровну делили русскоязычный трафик.

По информации «SEO аудитор» в 2017 году (в мае) Яндекс уступил Google в русскоязычном сегменте рынка по трафику.

В течение 2019 года Google имел долю рынка примерно 54−56 %, а Яндекс — 40−42 %. Можно сделать вывод, что Google медленно, но уверенно стал расти за счет увеличения доли мобильного трафика на устройствах с Android, на которых был предустановлен браузер Chrome.

Если вы серьезно намерены продвигать свой web-сайт, нужно выбрать приоритетную ПС

Почему это так важно? Потому что у каждого поисковика свои алгоритмы ранжирования. То есть то, что отлично работает в одной ПС, для другой может оказаться не актуальным

И наоборот. Так, в Яндекс можно попасть в топ-5 или 10, просто разместив на ресурсе полезную, интересную и качественную статью. В случае с Google, чтобы подняться, нужно оптимизировать код сайта и дополнительно наращивать ссылочную массу.

Какие сайты любят поисковики – 4 признака хорошего ресурса

Все поисковики стали требовательнее и жестче, особенно Яндекс. Системы постоянно разрабатывают различные фильтры и критерии, которые помогают оставлять на первых страницах выдачи действительно полезные и качественные сайты.

Таких фильтров – сотни, учесть их все почти невозможно. Но основные признаки ресурса, который нравится поисковикам, нужно знать обязательно.

Признак 1. Простая и понятная навигация

Думайте в первую очередь не о трафике, а о посетителях. Это разные вещи: трафик – предмет неодушевленный, а посетители – живые люди, которые пришли за пользой для себя. Если люди будут заходить и сразу же уходить, вершин поисковой выдачи вам не видать.

Признак 2. Уникальный и интересный контент

Контент – король, всё остальное свита. В фаворе только уникальное, качественное и интересное содержание. Крупные ресурсы имеют проверенных штатных авторов, которые знакомы со спецификой площадки и тематикой сайта.

Если статьи пишут исполнители с бирж, нужно отбирать исключительно профессионалов, которые не только увлекательно пишут, но и ориентируются в СЕО.

Признак 3. Единство стиля

Это касается фирменных шрифтов, заголовков, дизайна статей и страниц. В идеале любой материал должен быть оформлен в едином узнаваемом стиле. Это работает на имидж компании и формирует сообщество лояльных читателей.

Признак 4. Регулярное обновление

Бороться за внимание посетителей придётся постоянно. Пока сайт существует, поисковым продвижением (в той или иной степени) нужно заниматься ежедневно

Чем чаще на сайте появляются новые статьи, посты, записи в блоге, тем лучше ранжируется площадка в поисковиках.

Нюансы продвижения коммерческих сайтов в видеоролике:

Анализируем текущее положение с помощью SEO-инструментов

Раскрутка сайтов в Гугл имеет долгосрочную перспективу. Очень редко случается так, что сайт за месяц попадает в топ и держится там длительное время. Поэтому вам просто необходимо выбрать для себя пул SEO-инструментов, которые помогут отслеживать эффективность стратегии (кроме внутренних: Google Analytics и Search Console, о них чуть позже).

С помощью этого этапа мы можем увидеть свое “до”. Чтобы позже было с чем сравнивать. Особенно, если ваш сайт не новый. Как продвигать молодой сайт можно узнать в статье.

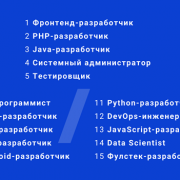

Какие инструменты мы рекомендуем:

- Ahrefs. Один из лучших SEO-инструментов для анализа состояния ссылочного профиля. Там можно увидеть и динамику прироста ссылок, и подробнее о донорах, анкор лист, распределение по типам ссылок и многое другое. Хорошо подходит как для анализа своего сайта, так и для сторонних площадок.

- CheckTrust. Покажет траст и спам сайта в пару кликов.

- Serpstat. Покажет текущий поисковой трафик, ситуацию с ключевыми словами и страницы-конкуренты.

- Pr-cy. Здесь можно посмотреть текущий общий трафик, географию сайта.

- Majestic. TrustFlow и CitationFlow.

Это основные 5 инструментов. Отдельно инструменты для анализа внешних ссылок мы рассматривали здесь.

Рекомендуем все данные, которые вы получили после полноценного анализа сайта, занести в отдельный документ для определения эффективности вашей стратегии ссылочного продвижения в Гугл в будущем

Определяем целевые страницы для продвижения в Google

Перед тем, как начать продвижение сайта под Google, определите целевые страницы, на которых вы будете делать акцент. В будущем этот список можно будет дополнить.

Чтобы выбрать страницы, ответьте себе на вопросы:

- Какие страницы вашего сайта наиболее конверсионные? Какие страницы наиболее популярны у аудитории, пользователи охотно с них переходят на страницы регистрации или покупки. Для этого необходимо грамотно настроить цели в Google Analytics. Как это реализовать вы найдете здесь.

- Какие страницы находятся около ТОПа по нужным ключевым запросам? Продвижение таких страниц поможет быстро увидеть желаемый результат.

- На каких страницах размещен наиболее маржинальный товар/услуга? Результатом продвижения таких страниц будет не только рост позиций, но и, возможно, рост прибыли компании.

- Какие страницы менее конкурентны в нише? Есть ли у вас уникальные страницы, которых нет у конкурентов ниши? Их продвижение принесет видимый эффект за меньший срок.

После того как целевые страницы будут определены, можно приступать к разработке ссылочной стратегии, главная задача которой — поднять сайт в поиске Гугл.

Как поднять сайт в Гугл: алгоритмы ранжирования

Врага надо знать в лицо… Поэтому давайте разберем все поисковые алгоритмы и фильтры Google.

- SandBox (Песочница) — один из самых первых фильтров Гугла. Появился в 2004 году. Смотрит на новые (молодые) сайты, сайты, которые изменили тематику и те, кто активно наращивает ссылочную массу сайта. Если попасть под этот алгоритм, то ваш сайт будет отображаться в кеше Гугла, но не будет появляться в результатах выдачи. Фильтр можно снять через полгода-год.

- Panda (Панда) — фильтр Гугла, который появился в 2011 году. Причина его появления — массовые жалобы на сайты в топе выдачи с неуникальным или вторичным контентом (копипастом попросту). Фильтр убирает с первых страниц выдачи поисковой системы сайты с копиями, переспамленным ключевыми словами контентом и сайты и пустые сайты.

- Penguin (Пингвин) — алгоритм Гугла, который появился в 2012 году. Направлен этот алгоритм на борьбу с поисковым спамом. Один из основных алгоритмов на ряду с Пандой. Опускает сайты в выдаче с неестественной ссылочной массой (с покупными низкокачественными ссылками, размещенными на спамных, нетематичных площадках). Пингвин работает автономно и без обновлений.

- Colibri (Колибри) — алгоритм появился в 2013 году. Основывается на поведенческих факторах пользователей. Гугл улучшил понимание синонимов и разделил контент по тематикам. Сейчас алгоритм наказывает за переспам конкретного ключевого слова.

- Mobile Friendly — алгоритм появился в 2015 году. Специализируется на пользовательской выдаче, которые пользуются поисковой системой не с ПК, а с гаджетов: мобильных, планшетов и т.д. Фильтр позволяет страницам с адаптивной версией ранжироваться выше в результатах. Штрафных санкций нет, но делать свой сайт удобным для мобильных пользователей желательно. Это увеличивает конверсию.

- Rankbrain — алгоритм появился в 2015 году и с тех пор не обновлялся. Предназначен для расшифровки запросов пользователей и предоставляет релевантные результаты в зависимости от контекста. Штрафует сайты за низкую релевантность пользовательскому запросу и за плохие поведенческие показатели.

- Fred — алгоритм появился в 2017 году. Предназначен для борьбы с нарушителями рекомендаций для вебмастеров и злоупотреблением некоторыми видами рекламы. Также наказывает сайты с большим количеством исходящих ссылок и контентом, написанным специально для генерации трафика.

- Bert — алгоритм появился 21 октября 2019 года. Работает над улучшением релевантности результатов поисковой выдачи за счет анализа предложений.

- Florida 2 — алгоритм появился в августе 2019 года. Анализирует контент по фактору E-A-T — экспертности, авторитетности и надежности. Анализирует качество ссылочного профиля, и учитывает авторитетность проектов.

Наличие мобильной версии

Последний фактор, о котором я хочу рассказать – это адаптация сайта под просмотр с электронных гаджетов – смартфонов и планшетов. Это совсем недавний, но устойчивый тренд. Он связан с растущим числом пользователей, выходящих в интернет именно с мобильных устройств.

Если сайт некорректно отображается на смартфонах, поисковик не поставит его на верхние позиции выдачи. Из этой ситуации есть 2 выхода: изначально сделать сайт или купить шаблон с готовой мобильной версией, либо заказать доработку существующего.

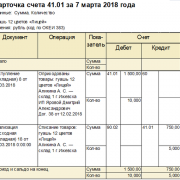

Закончу статью тем, с чего начал. Перед вами сводная таблица отличия ранжирования поисковыми роботами Google и Yandex

Из нее вы узнаете, на что обратить внимание при продвижении в каждом поисковике, за что могут наложить фильтры, а на что посмотрят сквозь пальцы

Таблица 1 – отличия в ранжировании поисковыми системами

Показатель ранжирования

Yandex

Поведенческие факторы

Ключевой фактор ранжирования, входящий в ИКС – индекс качества сайта. За накрутку накладываются фильтры

Официально не признает учет поведенческих, на самом деле использует данные из Google Аnalytics

Ссылочная масса

Можно успешно продвигаться вообще без ссылок. Учитываются только органические ссылки

Наложение санкций за покупные ссылки

Ссылки по-прежнему имеют важное значение при продвижении. В топе только сайты с большим числом внешних ссылок

Cанкций за накрутку не замечено

Ключевые слова

Отслеживает переспам по ключам при помощи алгоритма “Баден-Баден”. Есть возможность выйти в топ, не применяя ключевики вообще

Лояльно относится к использованию ключевиков

Коммерческие факторы

Учитывает. При некорректном запросе делает уклон в коммерческую выдачу

Нет данных

Наличие мобильной версии

Можно попасть в топ без адаптации под смартфоны и планшеты

Не пропускает на верхние строчки сайты, не имеющие мобильной версии. Компания исповедует политику приоритета мобильного трафика – mobile-first indexing

Технические параметры

Можно продвигать сайт с незначительными техническими ошибками

Серьезно понижает в рейтинге сайты с ошибками и те, что медленно работают

Геолокация

Можно настроить ранжирование по регионам при помощи поддоменов

Не учитывает

Текстовый контент

Можно продвигаться с небольшими текстами среднего качества

Лучше ранжируются большие экспертные статьи с примерами, фотографиями и конкретными данными

Юзабилити и UX

Учитывается как напрямую, так и при оценке поведенческих факторов

Учитываются

Надеюсь, статья оказалась полезной. Успехов при продвижении сайта в топ!

- Лучшие SEO сервисы

- Лучшие курсы по SEO-продвижению сайтов!

- Лучшие книги по SEO

- Что такое SEO? Руководство для начинающих

С чего следует начинать любой анализ

Помните, анализ важно начинать с полноценной оценки ТОПа и сравнению выдачи до и после апдейта. Это позволит вам быстрой отделить локальные подвижки (изменение позиции 1-3 сайтов) от глобального апдейта алгоритма/классификации запроса и существенно снизить круг возможных причин

Список литературы и ссылок для ознакомления

- Сообщить о новом сайте, Яндекс,http://webmaster.yandex.ru/addurl.xml

- Текстовые фильтры Яндекса: давайте различать, 19 ноября 2012, https://www.seonews.ru/analytics/tekstovye-filtry-yandexa-davayte-razlichat/

- Поиск Яндекса и контент для взрослых, 29 июня 2009, http://company.yandex.ru/rules/filtration/

- Что такое аффилированные сайты? Как аффилированность двух сайтов сказывается на занимаемых ими позициях, 2011, http://www.pixelplus.ru/poiskovoe_prodvizhenie_sajtov/faq/affilirovannost/

- Поиск с учётом региона, http://company.yandex.ru/technologies/regions/

- Сервис SEO hint, 2012, http://seohint.ru/

- Сервис MegaIndex, 2009, https://www.megaindex.ru/?tab=wordAnalyze&do=wordAnalyze

- Панель Вебмастера от Яндекса, http://webmaster.yandex.ru/

- Спектр, 2010, http://company.yandex.ru/technologies/spectrum/

- Нам не страшен злой Пингвин, 2012, https://www.seonews.ru/analytics/gde-iskat-otlozhennyy-spros/

- Как правильно сделать 301-редирект, http://www.pixelplus.ru/poiskovoe_prodvizhenie_sajtov/faq/301-redirekt/

Про поведенческие факторы

Поведенческие факторы – это все действия пользователя на сайте. Движения курсором, скроллинг страницы, клики по блокам и т. д.

Чем лучше эти поведенческие факторы, тем выше сайт будет в выдаче. Поисковые системы стремятся показывать пользователям наиболее релевантный контент.

Мы точно знаем какой оффер у тебя выстрелит

Подробнее

Их легко можно имитировать при помощи ботов, но такой тип накрутки очень быстро палится поисковиками. На виновника накладывается фильтр, который не дает подниматься на высокие места. Даже если использовать прокси и VPN, поисковики все равно смогут отследить поведение бота.

Еще некоторые новички думают накручивать ПФ через буксы. Но это тоже нецелесообразно. Поисковые системы легко палят мотивированный трафик.

Адекватная накрутка ПФ, которую не палят

Как же тогда накручивать ПФ? А все очень просто – все действия должны идти от реальных пользователей из разных городов, с разной историей поиска и т. д.

Организовать такое самостоятельно практически нереально. Можно, конечно, создать несколько заданий на биржах фриланса, но смысла нет – есть способы куда проще и дешевле. Да и биржевые исполнители вряд ли сделают все правильно, то есть эффекта не будет.

Речь идет о специальных сервисах, которые помогают накручивать поведенческие факторы более белым способом.

Если говорить просто, то в этих сервисах работают молодые люди, которые ходят по улицам разных городов и предлагают прохожим «оценить» ваш сайт. При этом они просят зайти на сайт через поисковик с использованием указанного вами запроса.

Один из таких сервисов – Юзератор. Они как раз занимаются накруткой ПФ. С этим проектом связано очень много кейсов. Однажды они даже опубликовали такой на ТексТерре.

В кейсе они продвигали сайт с помощью накрутки ПФ, вывели его в топ-1. После этого кейс заметили в Яндексе и забанили этот сайт на год. Самое интересное, что после окончания срока бана сайт вновь вылетел в топ-1 по продвигаемому запросу. И даже сейчас он там.

Если бы тогда этот кейс не опубликовали, никакого бана бы не последовало. Но это не точно.

Сейчас этим сервисом пользуется большое количество людей. Они продвигают свои блоги, коммерческие сайты или даже прокладки под определенные офферы.

Для использования нужно просто зарегистрироваться и создать проект. Внутри платформы есть много подробных инструкций, в которых описывается процесс работы. Так что проблем не будет даже у новичков.

В общем, сервис классный и с его помощью можно продвигаться. Спалить такое вряд ли смогут, но все может быть. Именно поэтому на сайт юзератора нельзя входить с Яндекс.Браузера – это повышает уровень безопасности для вас при продвижении.

Как на этом может заработать арбитражник

Арбитражники тоже могут зарабатывать на поисковом трафике. Им нужно просто создать сайт под определенный оффер и потом продвинуть его по нужному запросу через этот или аналоговый инструмент.

Такой способ слива может быть дешевле, чем контекст или тизеры. Но здесь есть свои издержки.

Во-первых, чтобы продвигаться через подобные сервисы ваш сайт уже должен быть хотя бы на первых 20 страницах по нужному запросу. Иначе люди просто не смогут зайти на него через поисковик.

Во-вторых, нужно тщательно продумать прокладку, которую вы будете продвигать. Она должна выглядеть максимально естественно. Вообще, круто было бы сделать небольшой малостраничник под оффер. Тогда залететь в топ можно намного быстрее.

В общем, чтобы заработать на этой схеме придется потратить время. Зато, в случае успеха, эта прокладка в топе долго будет приносить вам деньги

Если брать во внимание, что даже после бана продвигаемый ресурс остался на первой позиции, то это воодушевляет

На этом все. Удачных сливов, прибыльных связок и высокого апрува.

Как поднять сайт в поиске: особенности продвижения в Google в 2021

Кардинально правила продвижения в Гугл не поменялись

Но есть моменты, на которые стоит обратить свое внимание в 2021 году:

Адаптивная версия сайта

На оптимизацию под мобильные устройства сейчас Гугл обращает особое внимание. Как мы и говорили в начале статьи, если у вас нет адаптивной версии — стоит уделить этом время в первую очередь.

Внутренняя SEO-оптимизация и одновременно качественный, уникальный контент

Теперь тексты ради ключевых слов не работают. Кроме оптимизации, Гугл смотрит на сам контент и определяет его пользу для пользователя.

Расширяйте семантику. Следите за тенденциями в своей нише и старайтесь расширять семантику сайта новыми ключевыми запросами.

Оценка значимости поведенческих факторов. Чтобы занять лидирующие позиции в поисковой выдаче, следует адаптировать сайт под требования и удобство пользователей. Регулярно усовершенствуйте функционал и тестируйте юзабилити.

Качественный линкбилдинг. Планомерное наращивание качественной ссылочной массы сильно влияет на авторитетность сайта в Гугле.

Локальный поиск. Сейчас активно популяризируется продвижение локального бизнеса. Под это написано много крутых материалов, таких как этот.

Голосовой поиск. Оптимизация сайтов под голосовой поиск впервые появилась в 2017-2018. Но сейчас нее следует обратить особое внимание. Все больше пользователей пользуются голосовыми помощниками.

Переход на протокол HTTPS. Эра HTTP уже давно прошла. Сейчас довольно редко встречаются такие сайты. Если вы еще не перешли на HTTPS, рекомендуем заняться этим в ближайшее время. Поисковые роботы сейчас пристально следят за сайтами, которые выбились из общей массы.

Если учесть эти пункты перед тем, как рекламировать сайт в Гугл, то можно значительно ускорить процесс и достичь намеченной цели раньше поставленного дедлайна.

Значение всех функциональных элементов

Главная страница проверки

1 – Ссылка на главную страницу проверки

2 – Ссылка на страницу со всеми ранее проведенными проверками

3 – Информация о инструменте, именно её Вы сейчас и читаете

4 – Поле для ввода запросов

Обратите внимание, что в данном поле указано сколько запросов Вы можете проверить

5 – Регион проверки. В данном поле указывается регион, по которому производиться сбор информации.

6 – Глубина проверки. Здесь выбираем сколько результатов мы хотим получить для каждого запроса.

7 – Начать проверку. Запускаем инструмент.

Страница результатов проверки

1 – Название проверки. Формируется по первому запросу в списке.

2 – Информация о проверке.

- Дата проверки

- Число поисковых фраз

- Число фраз с корректным результатом

- Регион проверки

- Глубина проверки.

3 – Кнопки для расширения левой рабочей зоны с URL доменов и страниц на всю ширину экрана. Также смещает правую рабочую зону с результатами выдачи вниз. Полезно для анализа URL результатов выдачи.

4 – Кнопка «Скрыть выделенные запросы». Скрывает результаты выдачи по запросам, в которых нет выбранных доменов/документов.

6 – Кнопка для удаления проверки.

1 – Хост. Список всех хостов (доменов) в выдаче.

2 – Документ. Список всех уникальных документов (страниц) в выдаче.

3, 4 – Выбрать все. Подсвечивает все хосты/документы.

5, 6 – Показать все. показывает все найденные хосты/документы.

7 – Видимость. Видимость конкретного хоста/документа.

8 – Количество запросов, по которым найден данный хост/документ.

9 – Перейти. Позволяет перейти на данный хост/документ.

Правая рабочая зона

1 – Запрос по которому были получены результаты.

2 – Элемент Drag&drop. Позволяет перемещать результат по рабочей зоне.

3 – Включает/выключает отображение результатов по данному запросу.

4 – Номер позиции результата в выдаче.

5 – Элементы для выделения хоста/документа.

6 – Открывает/скрывает заголовок и описание сниппета результата выдачи.

7 – Заголовок и описание сниппета результата выдачи с выделенными подсветками Яндекса.

8 – Фавиконка.

9 – Позволяет перейти на выбранный документ.

Особенности продвижения новостных сайтов

-

ЗадачаНет задачи довести до какой-то конверсии, все сводится к максимизации трафика.

-

ЗапросыУ таких сайтов очень много запросов, как правило, они микроНЧ или вообще нечастотные. На высокочастотные запросы трафика приходится немного, поэтому даже если вывести по ним сайт в топ, серьезного прироста трафика не будет. Разве что для региональных изданий можно использовать запрос «новости города».

-

КонтентКонтент генерирует новостная редакция или пользователи, им почти невозможно управлять. Страницы привязаны к повестке дня, быстро устаревают, поэтому мониторить позиции в большинстве случаев бессмысленно — нужно попадать в быстровыдачу с событийным трафиком.

-

Методы продвиженияПоскольку отдельные страницы быстро устаревают, для продвижения интересны только массовые методы — то, что применяется на весь сайт или большие наборы страниц. В аналитике интересен трафик и средние показатели по сайту целиком или отдельным разделам.

Что такое быстровыдача?

Это технология Яндекса для обработки новостей и срочных материалов, работает отдельно от основного алгоритма ранжирования. С ее помощью новости появляются в индексе в течение нескольких минут после публикации на сайте. Спустя три дня их обрабатывает поисковый бот и они занимают место в основной выдаче.

Новости в выдаче Яндекса

Новости в выдаче Яндекса

В Google есть аналог быстровыдачи — колдунщик новостей над выдачей.

Новости в выдаче Google

Новости в выдаче Google

Факторы ранжирования в быстровыдаче, рекомендациях Google и Google News:

-

свежесть новости;

-

регулярность публикаций на площадке;

-

«хабовость» источника;

-

сигналы авторитетности — внешние ссылки.

Попасть в быстровыдачу могут только свежие новости с сайтов, которые публикуют их регулярно. Бот ориентируется на то, где появился материал, его интересуют значимые страницы-хабы, из которых он собирает список источников. Это могут быть агрегаторы новостей, Яндекс.Новости, социальные сети, главные и страницы категорий на сайтах. После того, как сайт попадет в список хабовых сайтов, бот будет посещать сайт регулярно.

Как генерировать посадочные под быстровыдачу

-

Если есть ядро запросов, которые могут выстрелить, можно подготовить контент под них. Либо создать шаблон вывода такого контента: видео, заголовок, генерация стандартного описания.

-

Поставить в расписание публикаций.

-

После публикации заняться дистрибуцией таких страниц: поставить ссылки со старого контента, с главной, ротатора ссылок, хабов на своем сайте и сайтах партнеров, подключить соцсети или форумы.

Количество мест в быстровыдаче зависит от важности новости. Чем «горячее» новость, тем больше ресурсов публикуют информацию и тем больше мест в выдаче

В выдаче Яндекса оказалось больше букмекерских сайтов, в Google больше новостей

В выдаче Яндекса оказалось больше букмекерских сайтов, в Google больше новостей